|

|

|

|

|

|

Зачем телекому большие данные

Круг задач, которые решаются с помощью технологий больших данных, становится все шире: это и маркетинговые исследования, и прогнозирование финансовых рынков, и даже обнаружение мошенничества.

Телекоммуникационные компании используют большие данные, чтобы снизить эксплуатационные издержки и повысить качество услуг связи. Сделать управление сетевыми сервисами и их развитие более эффективным им помогают гибкая и быстрая обработка «сырых» данных (row data) с узлов сети.

Откуда берутся большие данные в сети операторов?

«Сырые» данные поступают с сетевых элементов или из действующих систем управления сервисами (OSS, Operation Support System). Они отличаются глубокой степенью детализации сетевых событий: характер события на узле порождения услуги, обслуживание сигнальных пактов на каждом отдельном сетевом элементе и т.п. При обработке данные дополняются информацией из систем BSS (Business Support System, системы поддержки бизнеса), например данными об абонентах и предоставляемых услугах из биллинговых систем. Чем больше данных, тем точнее оперативный срез состояния сети: используемая и доступная емкость, качество сетевых сервисов, другие параметры.

В системах OSS существует много инструментов сетевого управления, позволяющих определить и отобразить статическую топологию сети. Но корректно оценивать сервисы в режиме реального времени такими средствами сложно. Тут требуется анализ всех доступных данных, а они не всегда имеют фиксированную структуру. К тому же информационная модель услуг постоянно меняется: появляются новые требования со стороны бизнеса, расширяются функциональные возможности услуг и взаимосвязь между сервисами.

Что можно сделать с этими данными?

Для качественного управления информационной моделью услуг важны два момента. Первый – оперативно и точно определять необходимый набор метрик из исходных данных в разных источниках для создания более точной информационной модели сервиса. Делать это без затрат на поиск нужных параметров и повторную загрузку можно благодаря тому, что исходные данные хранятся в «сыром» виде.

Второй – на основе полученных данных быстро формировать основу для предсказательной аналитики. С ее помощью операторы могут определять характер используемых ресурсов, прогнозировать возможные проблемы, быстрее разрабатывать новые услуги с использованием имеющихся, но пока не используемых метрик и параметров.

Поскольку фиксированная структура влечет за собой дорогие операции подготовки и трансформации данных, получил популярность подход к их хранению в так называемом общем или гибком формате.

В Vertica – платформе для анализа больших данных, разработанной компанией Micro Focus, – подобная технология называется flexible tables, или гибкие таблицы. Исходные данные загружаются в БД в «сыром» виде, без изменений. Все необходимые преобразования задаются прямо в процессе обработки данных: определяя так называемые карты отображений (map) либо используя кастомизированные функции трансформации (transformation UDx). Первый вариант подходит для хранения и обработки форматов CSV, JSON и XML. Второй позволяет работать с любым другим форматом, например, обрабатывать данные в формате ASN.1 BER.

В результате аналитик имеет полный доступ ко всей исходной информации в рамках одной экосистемы – делается это с помощью обычного языка структурированных запросов SQL, который хорошо знаком специалистам.

Подход к организации «гибких данных» не был бы эффективен, если бы не кластерная инфраструктура с массово-параллельной обработкой данных (MPP). Гибкие таблицы в Vertica организованы как обычные таблицы. Методы распределения данных между узлами кластера применимы к этим типам таблиц точно так же, как к фиксированным. Трансформация данных в них происходит параллельно на задействованных узлах кластера. Это увеличивает производительность обработки за счет горизонтального масштабирования. Аналитик мгновенно получает информацию из гибких таблиц и на их основе может гораздо быстрее принять решение и пересмотреть действующие аналитические модели.

Где протестировать платформу?

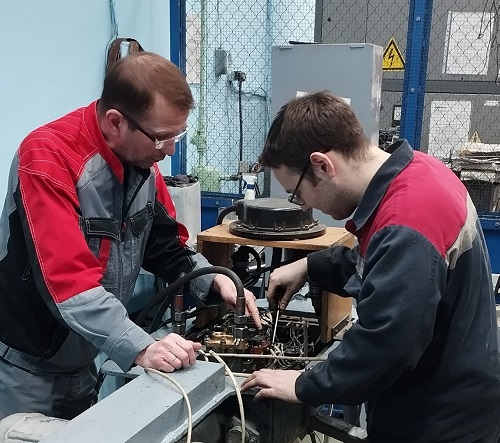

В Петербурге стенд Vertica развернут в демоцентре КОМПЛИТ. Здесь можно оперативно организовать любой пилотный и стендовый проект, на складе всегда в наличии оборудование нужной конфигурации. Есть подготовленные для технических испытаний площадки и собственный центр обработки данных.

На базе платформы Vertica специалисты компании реализовали проекты по созданию систем оценки качества связи. В них они решали задачи обработки информации о событиях в сети оператора, полученной из различных источников, ее «очистки» и нормализации. Проводили инженерный анализ коммерческих услуг, а также исследование корреляции событий по временным окнам.

В демоцентре вы можете протестировать платформу, учитывая задачи своего бизнеса.

Контактное лицо: Пресс-служба КОМПЛИТ (написать письмо автору)

Компания: компания КОМПЛИТ (все новости этой организации)

Добавлен: 21:11, 27.04.2018

Количество просмотров: 554

| Navicon и Адвантум стали партнерами, Navicon, 22:21, 02.03.2026, Россия |

56 |

| Системный интегратор и разработчик Navicon заключил партнерское соглашение с Адвантум, разработчиком ИТ-решений для управления транспортной логистикой. |

|

|

|

|

|

|

|

Разделы //

Новости по странам //

Сегодня у нас публикуются //

|

|